Eliezer Yudkowsky, ein bekannter Experte für maschinelles Lernen, forderte im Frühjahr 2023 die US-Regierung auf, Datencenter in Ländern unter Beschuss zu nehmen, die künftig die Obergrenzen für Rechenleistung zum Training eines KI-Systems überschreiten. Generative Künstliche Intelligenz, so die Befürchtung, könnte als Superintelligenz die Herrschaft über den Menschen übernehmen.

KI-Dooming gehört mittlerweile zum guten Ton bei vielen, die im Silicon Valley wahrgenommen werden wollen. Yudkowskys radikale Forderung vermittelt einen Eindruck davon, wie intensiv die Konsequenzen einer künstlichen Intelligenz diskutiert werden, die – in der Sicht der KI-Doomer – menschliches Leben auslöschen könnte.

Anlass für die emotionale Diskussion sind die so genannten Large Language Models (LLM), die Kerntechnologie von Chat GPT und anderen Sprachmodellen, die quasi das gesamte Wissen des Internets aufgesogen haben. Die nervöse Phantasie einiger Insider und KI-Forscher geht dahin, dass eines Tages daraus so etwas wie ein superkluges Bewusstsein entstehen und menschliches Leben unterwerfen könnte.

Die größten LLMs, wie diejenigen von Open AI und Google sind äußerst gefräßig: Sie werden auf mehr als 1 Billion Wörter trainiert, was über 250 englischsprachigen Wikipedias entspricht. Je größer sie werden, desto hungriger werden sie. Mittlerweile ist das Internet als Datenquelle für generalisierte KI fast abgefrühstückt. Viele Modellbauer schließen deshalb bereits Verträge mit Nachrichten- und Fotoagenturen ab. Andere versuchen, mithilfe von Algorithmen „synthetische“ Trainingsdaten zu erstellen.

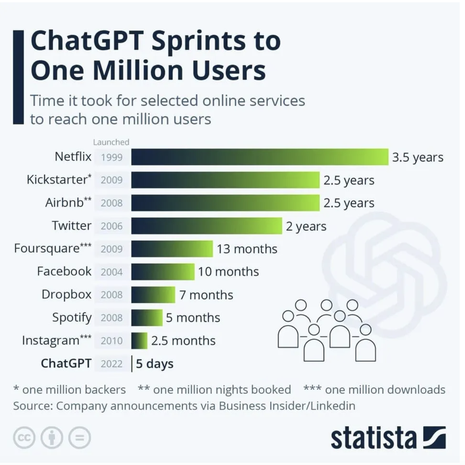

Bislang gibt es für die LLMs noch nicht DAS neue Gadget. Aber Chat GPT ist die Nutzeranwendung im Internet mit der steilsten Wachstumskurve. Zu den größten Risiken der Anwendung gehören unberechenbare Folgen auf dem Gebiet der Cyberkriminalität, der Desinformation und entsprechenden Szenarien, die Wissen und Wahrheitsbezug in der Gesellschaft komplett diffus machen könnten (total distrust). Klagen von der „New York Times“ und einer ganzen Reihe von Bestsellerautoren, die in den LLMs ihre Werke unrechtmäßig verwurstet sehen, sind bereits eingereicht.

Wo beginnen die Schwierigkeiten?

Ein Sprachassistent, der uns bei unserer täglichen Korrespondenz unterstützt, ist wahrscheinlich kein größerer Regulierungsfall. Ein Chat-GPT-Dienst, der einen Radiologen in der Diagnostik unterstützt, schon eher. Das Problem, vor das uns Chat GPT stellt, ist, dass die Algorithmen nicht wie bei älteren KI-Entwicklungen für klar definierte Zwecke geschrieben wurden, sondern für alle möglichen Zwecke eingesetzt werden können.

• Chat GPT kann nach wie vor die menschliche Welt nicht verstehen

Aus den Unternehmen, die LLG-Systeme entwickeln, wird bestätigt, dass Chat GPT und analoge Sprachmodell nach wie vor Black Boxes darstellen. Das bedeutet, dass die Sinnverknüpfungen, die die Systeme anbieten, von Menschen nach wie vor nicht nachvollziehbar sind. Doch wer vertraut einer Maschine, die bislang nicht in der Lage ist, unsere Alltagswelt zu verstehen, wichtige Entscheidungen in dieser Welt an? Simples Beispiel: Chat GPT soll in einem Bewerbungsverfahren entscheiden, wer die geeigneten Bewerber:innen sind. Nach wie vor kann nicht nachvollziehbar geklärt werden, ob die Maschine voreingenommen (biased) ist. Führt man sich vor Augen, dass Chat GPT seine „Textbausteine“ aus Twitter, Facebook, Rechtsradikalen und allen möglichen fragwürdigen Medien bezieht, ist es naheliegend, dass die Personalvorschläge ähnlich „biased“ ausfallen.

Im April des vergangenen Jahres machte Chat GPT irrtümlicherweise einen Juraprofessoren zum Mittäter bei einem Vergewaltigungsdelikt. Die Behauptung erwies sich als Systemfehler von Chat GPT. Recherchen ergaben, dass das Sprachsystem unsinnige Verknüpfungen zwischen Textteilen hergestellt hatte. Diese Verknüpfungen wurden von der KI als statistisch wahrscheinlich eingeordnet, sie galten aber als irrelevant. Das System stellte die Verknüpfung trotzdem her und hatte damit beinahe eine menschliche Katastrophe hervorgerufen.

• Big Tech baut am nächsten Monopol, was auch ein Forschungsmonopol werden könnte

Höchst problematisch bleibt, dass bei den LLMs die Big Techs (insbesondere Microsoft, Google und Amazon) längst die Grundlagenforschung übernommen hat. Von den 27 Milliarden US-Dollar, die KI-Start-ups im vergangenen Jahr einsammelten, kamen nicht weniger als zwei Drittel von den drei Big Techs. Klassische Venture-Capital-Firmen hatten zumindest 2023 das Nachsehen, auch weil sie an steigenden Zinsen und abstürzende Bewertungen ihrer Portfolios litten. Big Techs sind für Start-ups auf dem Feld der generativen KI ohnehin interessanter, weil das „Trainieren“ der KI große Speicherkapazitäten und jede Menge Geld verschlingt.

• Wem nutzt ein digitaler Assistent, der Lügen in die Welt setzt

Die Frage der inhaltlichen „Hallunzination“ (Konfabulation), damit sind von den LLMs glaubwürdig formulierte Tatsachenbehauptungen gemeint, die der Faktenlange nachweislich widersprechen, steht im Mittelpunkt vieler Bedenken. Die Gegenargumente aus der KI-Branche sind wenig überzeugend: Je mehr Fälle in die Öffentlichkeit kommen, umso weniger Gefahren entstehen, umso besser lassen sich solche Fällen kontextualisieren. Aidan Gomez, Co-Gründer von Cohere, einem kanadischen Start-up, das generative KI entwickelt, formuliert es so: „You try to add friction points into misuse. You add safeguards, like monitoring tools which tell you if someone has signed up and is starting to generate content which looks problematic or toxic, and you flag that extremely quickly and you kick them off the platform and ban their IP.” Das klingt wenig überzeugend. Solche Reaktionen greifen zu kurz, dann hätten sich womöglich auch die Wahlbeeinflussungen ab 2015 vor allem in den USA schnell eingrenzen lassen. Doch die „Weisheit der Vielen“ hat sich bekanntlich als verhängnisvolle Illusion herausgestellt.

• Einen Aufpasser für Chat GPT?

Aus der Branche, auch das erstaunt, wird immer wieder darauf verwiesen, dass die generative KI eben nicht als automatisierter End-to-end-Prozess „alleine gelassen“ werden dürfe. Es brauche den berühmten Human-in-the-loop (HTL), ein kompetentes Individuum, das der KI-Textmaschine auf die Finger schaue. Wer soll das sein? Doch wie sollen Vernetzungsprozesse gestaltet werden, die den Gymnasiasten beim Physiklernen und die Krankenschwester bei medizinischen Fragen kritisch die Hintergründe erläutern? Wer braucht digitale Assistenten, die digitale Assistenten brauchen?

• Die Digitalisierung der Gesundheit wird durch generative KI schon bald auf einem neuen Niveau stattfinden

ChatGPT wird sich 2024 als Assistenzsystem für jedermann etablieren. Aber wer vertraut beim alltäglichen Kleinklein einer Maschine, dessen Ergebnisse er im Grunde alle permanent nachprüfen muss? Generative KI wird menschliches Versagen in der Medizin minimieren. Der Gesundheitsbereich wird in den kommenden Jahren ein zentraler Schauplatz für die Weiterentwicklung der KI sein. Hochgradig individuelle Assistenten, die mit persönlichen bis intimen Informationen gefüttert werden und so die Gesundheit des einzelnen sicherstellen, stellen ein verlockendes Geschäftsmodell dar. Gleichzeitig entstehen hierbei auch massive Risiken, wenn beispielsweise falsche oder unpräzise Empfehlungen bei Medikamenten in Umlauf kommen.

• EU reklamiert Führungsrolle bei KI-Regulierung

Die EU hat sich im „Artificial Intelligence Act“ bereits mit ersten Regulierungsvorschlägen nach vorne gewagt. Die Vorschläge werden bewusst als vorläufig kommuniziert. Und es fragt sich, warum sie unter solchem Zeitdruck und so vorläufig veröffentlicht werden mussten. Im Großen und Ganzen ergaben die Nachtsitzungen der EU-Experten, dass erst einmal nur die großen und einflussreichen LLM-Modelle strikter reguliert werden. Klar ist, dass Verstöße der KI-Anbieter mit Bußgeldern bis zu 35 Millionen Euro oder sieben Prozent des Jahresumsatzes eines Konzerns geahndet werden können. Insider bezweifeln, ob ein KI-Headquarter in Brüssel und jede Menge Abwägungsspielraum vor Ort in den Ländern ausreicht, um handlungsfähig zu sein. Offenbar bauen die EU-Akteure auf den Brüssel-Effekt, der bereits bei der Datenschutzgrundverordnung (DSGVO) dazu führte, dass sich die Big Techs daran orientierten und viele Nicht-EU-Staaten die Verordnung als Grundlage für die eigene Gesetzgebung nutzten.

• Wer hat ein Interesse an Begleitforschung, die Chat GPT reguliert?

Vorschläge für eine „International Agency for AI, IAAI“, dem Vorbild der Internationalen Atomenergie Agentur (IAEO) folgend, liegen ebenfalls auf dem Tisch. Hochgradige Experten wie Gary Marcus, Gründer von Geometric Intelligence, einem Pionierunternehmen für maschinelles Lernen, fragen zurecht, wie das Geschäftsmodell für KI-Monitoring und -Forschung aussehen solle, quasi einer permanenten Begleitforschung, die das Biest zähmt und in die Schranken weist.

Spätestens an diesem Punkt wird die Frage unausweichlich, wie eine schnelle Institutionalisierung der KI-Forschung umgesetzt werden kann.